Nemotron 3 - Nvidia débarque dans l'open source et crache du token comme jamais

Vous voulez faire tourner un modèle d'IA en local sans avoir besoin d'un serveur de la NASA ? Eh bien Nvidia vient de lâcher une bombe avec Nemotron 3, une famille de modèles open source plutôt impressionnant et surtout, ils ont publié leurs données d'entraînement afin de jouer la transparence totale. Chapeau !

Le modèle phare de cette nouvelle famille s'appelle Nemotron 3 Nano et c'est un modèle de 30 milliards de paramètres, mais attention, il n'en active que 3,5 milliards à la fois grâce à une architecture hybride qui mélange du Mamba-2 et du Mixture-of-Experts ( MoE ). Ça permet de garder des performances de ouf tout en restant léger niveau ressources.

Sous le capot, Nvidia a également mis le paquet puisque le modèle a été entraîné sur 25 trillions de tokens. J'ai bien dit "trillions"... Pour vous donner une idée, les données d'entraînement incluent du Common Crawl de 2013 à 2025, du code dans 43 langages différents, des articles scientifiques, et une tonne de données synthétiques générées par d'autres modèles. Et tout ça, Nvidia l'a rendu public donc vous pouvez télécharger les datasets sur Hugging Face et vérifier par vous-même ce qui a servi à entraîner le bouzin.

Côté performances, Nemotron 3 Nano se défend plutôt bien . Sur les benchmarks de raisonnement mathématique comme AIME25, il atteint 99,2% quand on lui donne accès à des outils. Sur le coding avec LiveCodeBench, il tape du 68,3%, ce qui le place devant Qwen3-30B. Et pour les tâches d'agent logiciel genre SWE-Bench, il monte à 38,8%. Pas mal pour un modèle qu'on peut faire tourner sur du matos grand public.

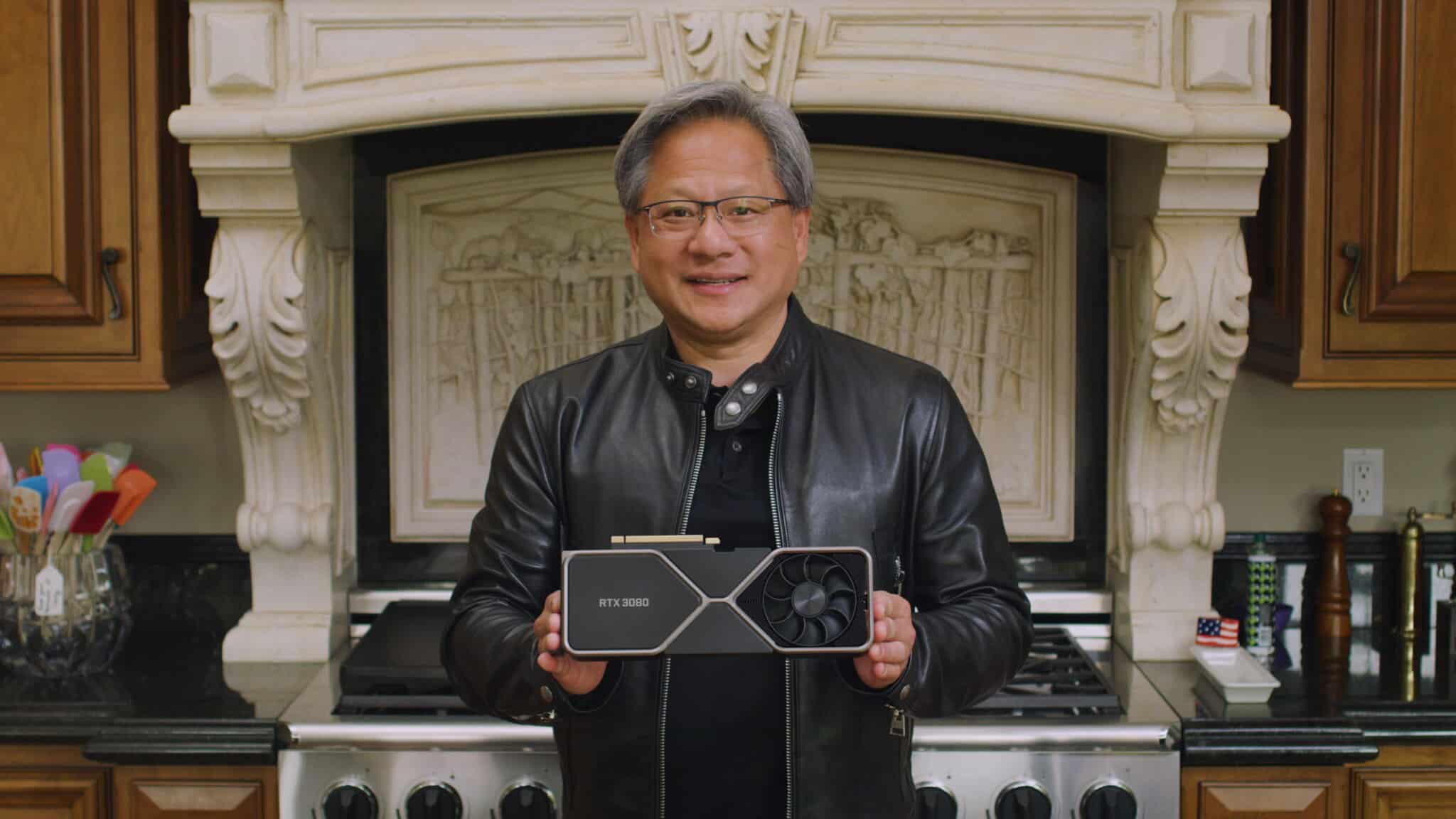

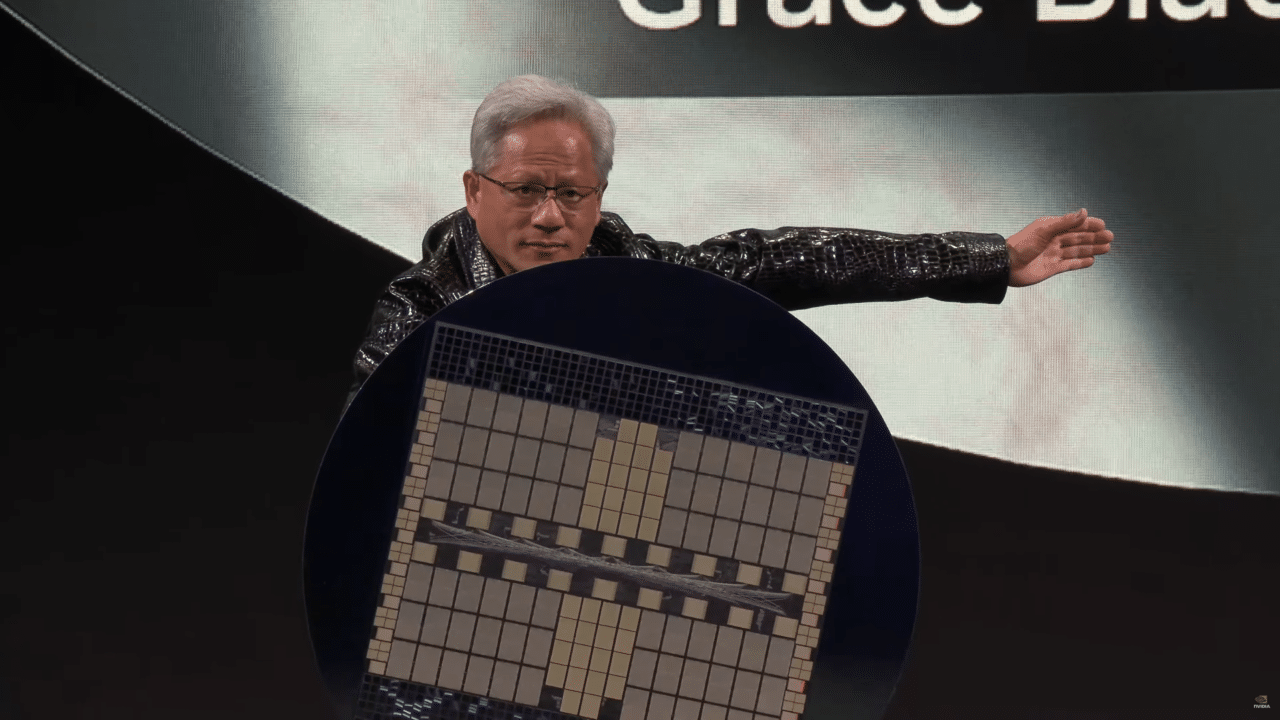

D'ailleurs, parlons du matos justement. Nemotron 3 Nano tourne sur des cartes comme la H100, la A100, ou même la future RTX PRO 6000 et supporte jusqu'à 1 million de tokens en contexte si vous avez assez de VRAM. Et niveau vitesse, Nvidia annonce un débit de tokens 4 fois supérieur à la génération précédente, avec 60% de tokens de raisonnement en moins. C'est donc exactement ce que tout le monde demande à saoir du token qui sort vite pour les workflows agentiques.

Maintenant, pour l'utiliser, c'est hyper simple. Il est dispo sur Hugging Face, et vous pouvez le lancer avec Transformers, vLLM, TensorRT, ou même llama.cpp. Y'a même un mode "thinking" qu'on peut activer ou désactiver selon si on veut du raisonnement poussé ou des réponses rapides.

Pour ma part, je l'ai testé à l'aide d'Ollama comme ceci :

ollama run nemotron-3-nano:30b

J'ai trouvé que vitesse de génération était vraiment impressionnante, ça débite beaucoup plus qu'un Llama 3 qui est de taille équivalente. Après, je suis sur un Mac M4 avec 128 Go de RAM, donc je suis plutôt bien loti mais j'ai trouvé ce modèle vraiment très rapide. Je pense que je vais vraiment m'en servir pour des trucs comme de la qualification, du résumé, de l'analyse ce genre de choses.

A voir maintenant si en français il s'en sort bien sur les tournures de phrases. Quoi qu'il en soit pour du développement et des workflows agentiques, il n'y a pas photo, ça va être mon nouveau modèle par défaut quand j'ai besoin de choses en local.

La famille Nemotron 3 ne se limite pas au Nano évidemment. Y'a aussi le Super avec environ 100 milliards de paramètres pour les applications multi-agents, et l'Ultra avec 500 milliards pour les tâches vraiment complexes. Ces deux-là arriveront au premier semestre 2026 donc faudra encore être un peu patient. Nvidia a aussi sorti des bibliothèques comme NeMo Gym pour l'entraînement et NeMo RL pour le fine-tuning.

Jensen Huang, le patron de Nvidia, a aussi dit un truc intéressant lors de l'annonce : "L'innovation ouverte est le fondement du progrès de l'IA." Venant d'une boîte qui a longtemps joué la carte proprio sur ses technos, je trouve que c'est un sacré virage et des entreprises comme Accenture, Deloitte, Oracle, Palantir, ou même Cursor sont déjà en train d'intégrer Nemotron dans leurs produits.

Ce qui est cool aussi, c'est que le modèle supporte 24 langues officielles de l'UE plus une dizaine d'autres comme l'arabe, le chinois ou le japonais et côté code, il gère Python, C++, Java, Rust, Go, et même du CUDA. Bref, c'est plutôt polyvalent.

Voilà, donc si vous cherchez un modèle open source sérieux avec des données d'entraînement transparentes et une vitesse de génération qui arrache, Nemotron 3 Nano mérite clairement le coup d’œil !

Entre pénuries, hausses de prix et choix stratégiques, le marché des cartes graphiques en 2025 a profondément évolué. Bilan de la situation

Entre pénuries, hausses de prix et choix stratégiques, le marché des cartes graphiques en 2025 a profondément évolué. Bilan de la situation La situation du marché des cartes graphiques commence à inquiéter, avec les premiers signes tangibles de hausses de prix. Elles rappellent de mauvais souvenirs aux joueurs.

La situation du marché des cartes graphiques commence à inquiéter, avec les premiers signes tangibles de hausses de prix. Elles rappellent de mauvais souvenirs aux joueurs.

Les GeForce GTX 900 et GTX 10 ne recevront plus de pilotes Game Ready. NVIDIA entame leur dépréciation mais continuera d’assurer des mises à jour de sécurité.

Les GeForce GTX 900 et GTX 10 ne recevront plus de pilotes Game Ready. NVIDIA entame leur dépréciation mais continuera d’assurer des mises à jour de sécurité. La RTX 5070 de NVIDIA grimpe dans le classement de l’enquête matérielle Steam et dépasse la RTX 4070. La série RTX 50 s’impose,

La RTX 5070 de NVIDIA grimpe dans le classement de l’enquête matérielle Steam et dépasse la RTX 4070. La série RTX 50 s’impose, Intel dépasse pour la première fois 1 % de part de marché sur le marché des cartes graphiques. Nvidia et AMD dominent le marché.

Intel dépasse pour la première fois 1 % de part de marché sur le marché des cartes graphiques. Nvidia et AMD dominent le marché.

Face à une pénurie mondiale de mémoire, NVIDIA envisagerait de ne plus fournir de kits GPU+mémoire à ses partenaires laissant aux fabricants la responsabilité d’acheter eux-mêmes la VRAM.

Face à une pénurie mondiale de mémoire, NVIDIA envisagerait de ne plus fournir de kits GPU+mémoire à ses partenaires laissant aux fabricants la responsabilité d’acheter eux-mêmes la VRAM. Les ventes mondiales de GPU repartent à la hausse en 2025, avec une croissance de 2,5 % ce trimestre et un gain notable de parts de marché pour AMD

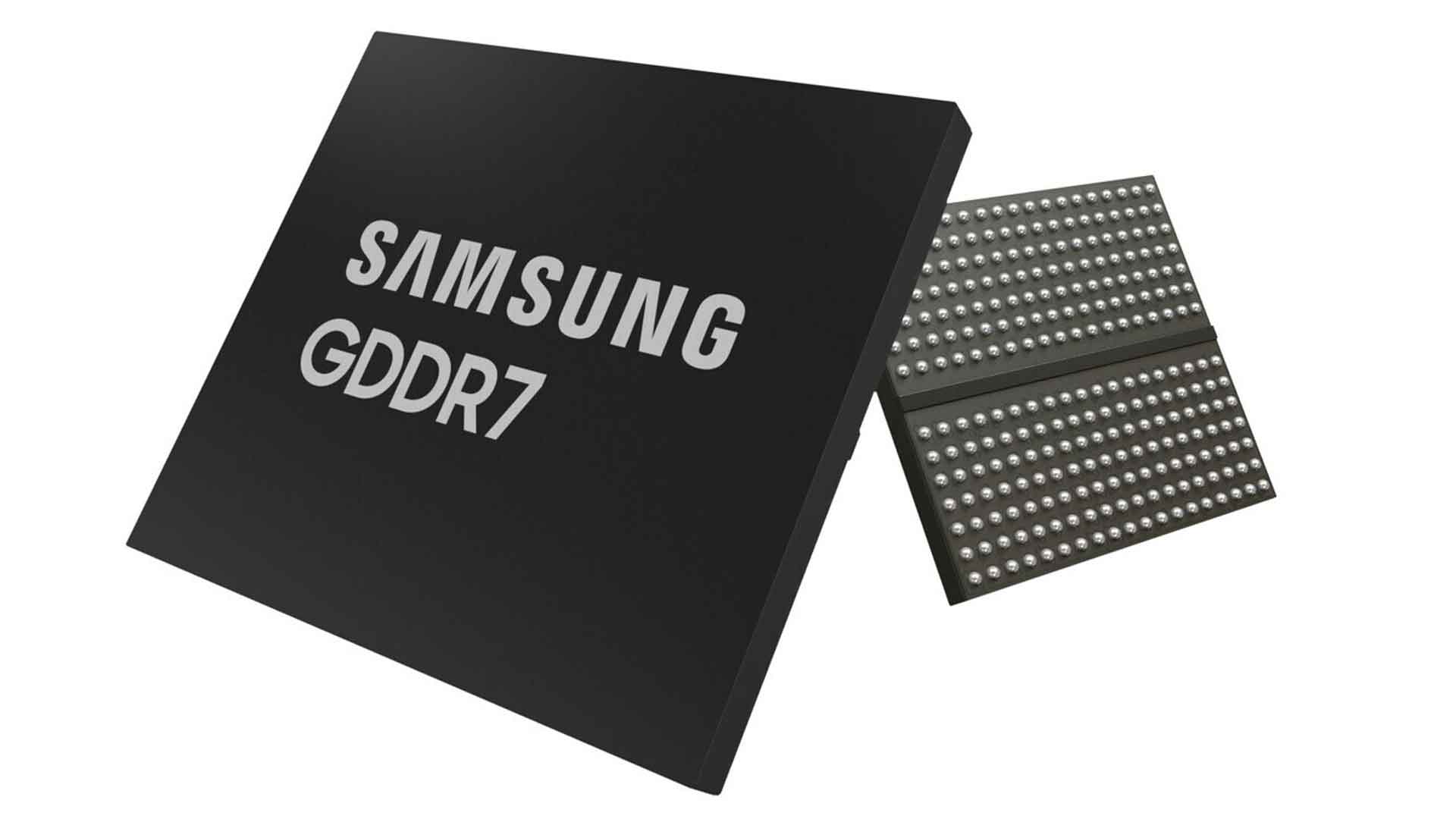

Les ventes mondiales de GPU repartent à la hausse en 2025, avec une croissance de 2,5 % ce trimestre et un gain notable de parts de marché pour AMD Samsung teste des modules GDDR7 à 36 Gbps, une vitesse record destinée aux futures cartes graphiques. NVIDIA prépare sa gamme RTX 50 SUPER

Samsung teste des modules GDDR7 à 36 Gbps, une vitesse record destinée aux futures cartes graphiques. NVIDIA prépare sa gamme RTX 50 SUPER

NVIDIA déploie un pilote Hotfix pour corriger les baisses de performances liées à la mise à jour Windows 11 d’octobre 2025.

NVIDIA déploie un pilote Hotfix pour corriger les baisses de performances liées à la mise à jour Windows 11 d’octobre 2025.